databricks:GCPで利用を開始する

databricksがGCPに対応し、Marketplaceから簡単に使い始められるようになりました。

公式ドキュメントDatabricks documentation | Databricks on Google Cloud を参考に、利用開始までの手順を紹介します。

事前準備

- GCPの請求アカウントが必要です。

- クオータの設定が必要です。下記の値がデフォルトから変更が必要となるため、IAMの”割り当て”より割り当てを実施します。

| クオータ名 | 最低限の推奨値 | スケーラビリティが求められる際の推奨値 |

|---|---|---|

| compute.googleapis.com/cpus | 60 | 2500 |

| compute.googleapis.com/n2_cpus | 50 | 300 |

| compute.googleapis.com/ssd_total_storage | 7.5TB | 50TB |

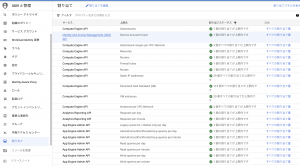

- プロジェクトで必要なAPIを有効にします。「APIとサービス」より下記のAPIが有効化されているか確認、有効化されていない場合は有効化します。

| Google API | API名、設定へのリンク |

|---|---|

| storage.googleapis.com | Cloud Storage API |

| container.googleapis.com | Kubernetes Engine API |

| deploymentmanager.googleapis.com | Cloud Deployment Manager V2 API |

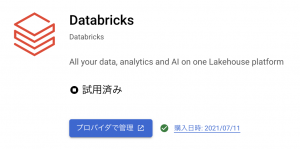

Marketplaceからdatabricksの登録

GCPのMarketplaceより、Databricksを選択します。

登録を完了すると、すぐに使えるようになります。

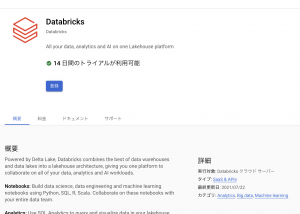

「プロバイダで管理」から進み、ログイン画面に。

Sign in with Googleより、Googleアカウントでdatabricksにログインします。

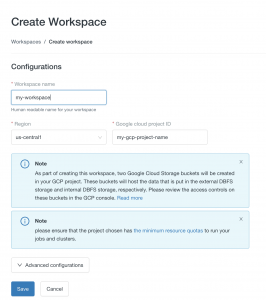

Workspaceの作成

ここからはdatabricksの初期設定です

「Create workspace」にて新しくWorkspaceを作成します

- Workspace name: 好きな名前を設定

- Region: databricksのクラスタを起動するリージョンを設定

- Google cloud project ID: GCPのプロジェクトIDを設定

「Save」でWorkspaceを作成します

作成したWorkspaceをopenすると、databricksの画面になります

これで利用できるようになりました。

Clusterを起動しなければ新たな課金は発生しないので、何時でも使えるように準備しておくと良いです

ブログへの記事リクエストはこちらまでどうぞ。